SEonthebeach 2019. Día 2: ponencias internacionales

09 julio 2019

La segunda jornada del congreso contó con un gran número de ponentes internacionales, entre los que destacaba Gary Illyes, trabajador de Google

Continuamos el resumen de SEOnthebeach, con las ponencias del segundo día del congreso, el 15 de junio.

The Truth about SEO Data, con François Goube

François Goube, fundador de Oncrawl, abrió la segunda jornada del congreso para contarnos la verdad de los datos en SEO. Su primera reflexión fue que, debido al gran número de herramientas actuales, el SEO ahora es procesar datos. Así pues, se hace necesario adoptar un enfoque más científico, tenemos que dejar de apostar y comenzar a predecir. De la misma forma, es necesario controlar hasta el mínimo detalle de los datos: comprenderlos, manipularlos y analizarlos. También dotar de valor a los datos con el conocimiento que cada uno de nosotros tenemos de nuestro negocio.

A continuación, explicó un método para el trabajo con datos, siguiendo también el método científico, tal y como había hecho Ricardo Tayar la jornada anterior. El método trataba de formular hipótesis a partir de observaciones y luego realizar pruebas para definir, modificar o rechazar dichas hipótesis.

Como ya había indicado al principio, François repitió que nos encontramos en la era de los datos en el SEO. Así pues, siguió la presentación con varios ejemplos de datos usados para entender el comportamiento de los bots de Google, como por ejemplo cuando está renderizando Javascript o cuando Google va a mover nuestra web al índice de Mobile First. Otro ejemplo que mostró fue sobre factores de posicionamiento que afectan al comportamiento de los bots, así pudimos ver cómo a mayor número de palabras en una página aumenta su rastreo, también aumenta cuando disminuye el número de carga de la página, cuando tiene un mayor número de enlaces o cuando presenta un H1 único.

Seguidamente, comentó algunos puntos que incidían sobre métricas de negocios desde un punto de vista SEO:

- Las páginas de monetización deben localizarse lo más cerca posible de la página de inicio.

- Las páginas con mayor tasa de conversión han de colocarse lo más cerca posible de la página de inicio.

Sobre la eliminación de páginas inactivas, dijo estar de acuerdo sólo si primero se había comprobado que dichas páginas no están generando ingresos, en cuyo caso la página debería dejarse.

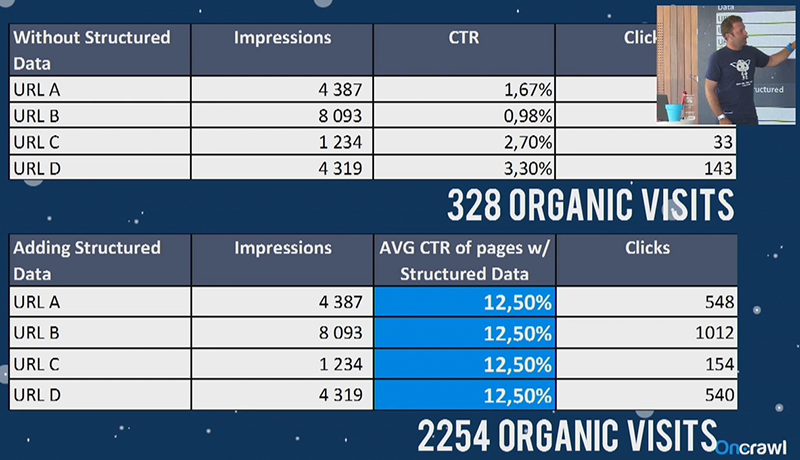

Las páginas con datos estructurados consiguen un mayor CTR. François nos instó a usar los datos para crear predicciones acerca de qué resultado tendrá una acción SEO concreta. Por ejemplo, modificar las longitudes de las descripciones o tener un título diferente para cada página.

Ejemplo de aumento de visitas con datos estructurados por François Goube

Ejemplo de aumento de visitas con datos estructurados por François Goube

También expuso la utilidad de coger una estimación de tráfico a partir de datos de SEMrush para resultados que no tengan mucha competencia.

Dentro de Google Search Console contó cómo detectar señales dentro del ruido de todos los datos. En este caso, se trata de hacer una predicción a futuro encontrando páginas que ya existen y que van a generar tráfico SEO adicional en los próximos meses. Esto se puede realizar comparando las impresiones en 2 periodos de tiempo y viendo cuáles son las páginas que tienen un mayor crecimiento.

Como últimos consejos, François señaló que debemos pensar como si fuéramos el dueño del negocio, ser inteligentes y repetir mucho para aprender.

Chuiso, revisando a los revisores de Google

La jornada continuó con Chuiso dispuesto a hablar sobre los revisores de Google. En primer lugar, quiso contestar a la pregunta, ¿quiénes son estos revisores? Estos son algunos datos al respecto:

- No trabajan para Google, sino para empresas externas.

- Son unos 10.000 en todo el mundo, para todos los idiomas. En español pueden ser unos 1.000, pero ésta es una cifra estimada por Chuiso, no hay datos oficiales.

- Hacen múltiples tareas, no solo revisar los resultados del buscador y las páginas, también revisan imágenes, anuncios y vídeos.

Los requisitos para ser Quality Rater (revisor) son:

- Firmar varios contratos (de trabajo, de confidencialidad, etc.).

- Pasar varios exámenes.

Se pueden encontrar opiniones de evaluadores y la mayoría de ellas son positivas.

La guía para evaluadores de búsqueda, aunque se supone que no debe ser pública, se puede encontrar en varias fuentes en el propio buscador de Google. Se actualiza anualmente y es habitual encontrar artículos acerca de los cambios respecto a la versión anterior. Estos son los principales puntos de la guía:

- Sirve para aprender a evaluar, principalmente, resultados de búsqueda.

- Incluye mucha información útil para SEO.

- Trata conceptos importantes como page quality (para escritorio), need mets (móvil), EAT (en español, experiencia, autoridad y fiabilidad) y los sitios YMYL (your money, your life).

- Tiene múltiples ejemplos de valoraciones y justificaciones para cada valoración.

- El objetivo principal es que la dirección URL analizada resuelva con total satisfacción el propósito de la consulta analizada.

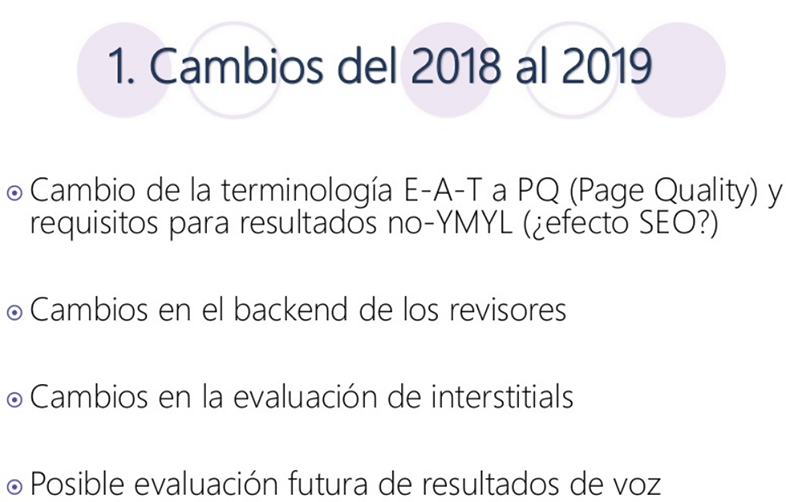

A continuación, Chuiso comentó los principales cambios de la guía del 2018 al 2109. Se dejó de utilizar tan a menudo la terminología EAT (Expertise, Authoritativeness y Trustworthiness) y se pasó a hablar más de PQ (Page Quality) y otra serie de requisitos para páginas que no sean YMYL, ya que éstas van a seguir teniendo un nivel de revisión más alto que cualquier otra página. También hubo cambios en el backend de los revisores, en la forma de evaluar la publicidad interstitials (que no hay problema en que estén siempre y cuando se puedan cerrar fácilmente) y se pedía a los evaluadores que contaran con un teléfono con micrófono o unos auriculares con micrófono, probablemente para una evaluación futura de resultados de voz.

Principales cambios de la guía para evaluadores de Google de 2018 a 2019

Principales cambios de la guía para evaluadores de Google de 2018 a 2019

Seguidamente habló de un post de Matthew Woodward, autor de un blog de marketing digital inglés, en el que explicaba cómo poder ver en Google Analytics si tu sitio web había sido revisado. Además, instó a sus lectores a indicarle si después de que los revisores hubieran pasado por su web habían visto algún cambio en su tráfico SEO y, tanto para subidas como bajadas, todos los sitios habían sufrido alguna variación después de haber sido revisados.

Puntos destacables de la guía:

- Los revisores trabajan sin bloqueadores de anuncios y usan operadores avanzados para las búsquedas (por ejemplo: “review” site:www.tuweb.com).

- Clasifican las páginas web en 3 tipos: de ayuda al usuario, de generación de dinero y dañinas.

- También se habla de verticales: de noticias, wikis, de vídeo, páginas oficiales, foros, preguntas y respuestas, etc.

Páginas YMYL son las que pertenecen, entre otras, a las siguientes categorías: páginas de transacciones, de información financiera, de información médica, de información legal, adopción, seguridad vial, etc.

Conclusiones finales:

- Los evaluadores tienen un efecto real en los resultados de las páginas que evalúan.

- Google es muy transparente si lees la información entre líneas.

- Todo lo que intuyamos o analicemos tendrá un carácter especulativo.

- Merece la pena leerse la guía para evaluadores.

En busca del SEO Feliz, por Juan González Villa

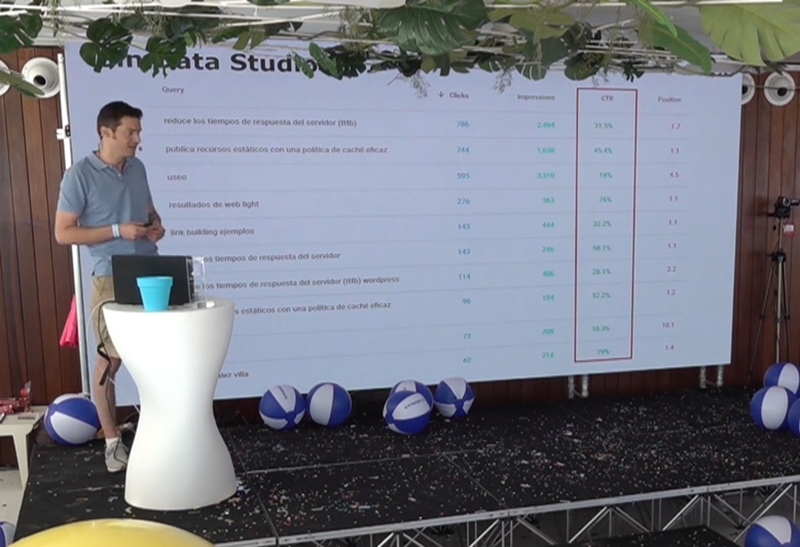

Juan González Villa, director de la agencia USEO saltó al escenario para hablar de los usos que hace de la herramienta de Google Data Studio y cómo la aplica a tareas SEO.

En primer lugar, explicó qué es Google Data Studio, una herramienta de visualización de datos que permite la creación de informes y paneles fáciles de leer y de compartir. Los datos que podemos usar en Data Studio van desde los propios de Google (Analytics, Search Console, Ads, etc.) hasta base de datos, medios sociales (Facebook o Twitter) y archivos CSV.

Juan González Villa impartiendo su ponencia

Juan González Villa impartiendo su ponencia

Juan compartió múltiples ejemplos de SEO en las categorías de análisis de datos, automatización de informes y tareas y procesos SEO.

Análisis de datos

El ponente indicó que hay actualmente 18 conectores oficiales en la herramienta y más de 160 desarrollados por la comunidad Open Source. Entrando ya en el análisis de datos, lo primero que hizo fue indicar otra prueba de la versatilidad de Data Studio, y es que cualquier herramienta que nos permita descargar datos en CSV se puede conectar a Data Studio, así como también cualquier herramienta que tenga API.

Automatización de informes

Por ejemplo, mediante los conectores de Google Analytics y Search Console podemos automatizar nuestros informes SEO.

Tareas y procesos SEO

Las tareas y procesos SEO que Juan utilizó de ejemplos de visualización en Visual Studio fueron:

- Mejora de Titles y CTR.

- Rastreo.

- Auditoría de perfil de enlaces.

- Estudio de la competencia.

Bonus

Como añadido, mostró cómo utiliza Visual Studio para la realización de presupuestos y diagramas de Gantt para sus clientes.

¿Y qué voy a conseguir haciendo SEO? Carlos Estévez

La charla de Carlos Estévez, director de Search Marketing y analítica web en Internet República, consistió en responder a la pregunta que tantas veces han hecho los clientes a los profesionales del SEO “¿y qué voy a conseguir haciendo SEO?

Para dar una respuesta realista a esta pregunta, Carlos propuso la siguiente fórmula:

TRÁFICO ESTIMADO = Volumen de búsquedas x CTR de la posición

El volumen de búsquedas se puede sacar de nuestra herramienta SEO favorita (Ahrefs, MOZ, SEMrush, etc.), o de Search Console cuando sea de proyectos propios o a los que tenemos acceso.

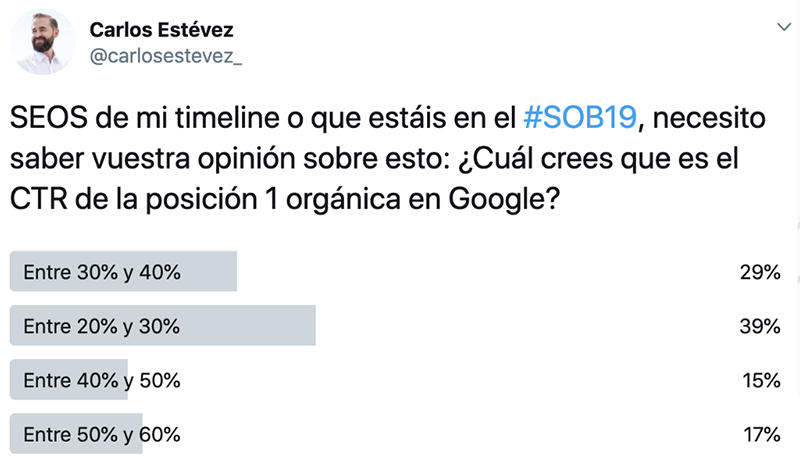

Para calcular el CTR de la posición podemos basarnos en nuestra propia estimación (Carlos hizo una encuesta en Twitter para ver qué opinaban los profesionales del SEO al respecto), datos de terceros que hay publicados por Internet o hacer un estudio a partir de datos propios.

Encuesta en Twitter de Carlos Estévez para conocer el CTR de la posición 1 orgánica en Google

Encuesta en Twitter de Carlos Estévez para conocer el CTR de la posición 1 orgánica en Google

Carlos mostró a continuación el estudio que habían hecho ellos sobre el CTR a partir de datos mensuales de más de 300 millones de impresiones, casi 38 millones de clics y más de 1.250.000 palabras clave. Obtuvieron una media de 43,85 % de CTR para la primera posición.

A continuación, explicó cómo debemos segmentar los términos de búsqueda para que sean más efectivo:

- Calcular el CTR para cada segmento.

- Combinando:

- Búsquedas de marca.

- Nº de palabras.

- Intención de búsqueda de las SERP.

Para finalizar, ofreció unas directrices para hacer una estimación realista del tráfico esperado:

- No hay que fiarse del Keyword planner de Google acerca del volumen de búsquedas de una palabra clave.

- Debemos segmentar nuestras keywords por marca, dispositivo, número de palabras y posición real en la SERP.

- Hay que tener en cuenta que no vamos a superar a Google detectando la intención de búsqueda de los usuarios.

- Utilizar nuestros datos de Search Console y AdWords.

El papel de la semántica en el rankeo de URLs, de Carlos Pérez

Carlos Pérez, CTO en Safecont, comenzó la charla con una primera pregunta: ¿Qué dirección URL de tu sitio responde correctamente a lo que busca el usuario?

Esto nos lleva directamente a la segunda pregunta, que el ponente tituló “el problema del rankeo” y es ¿cuál es la página web que mejor responde a la consulta?

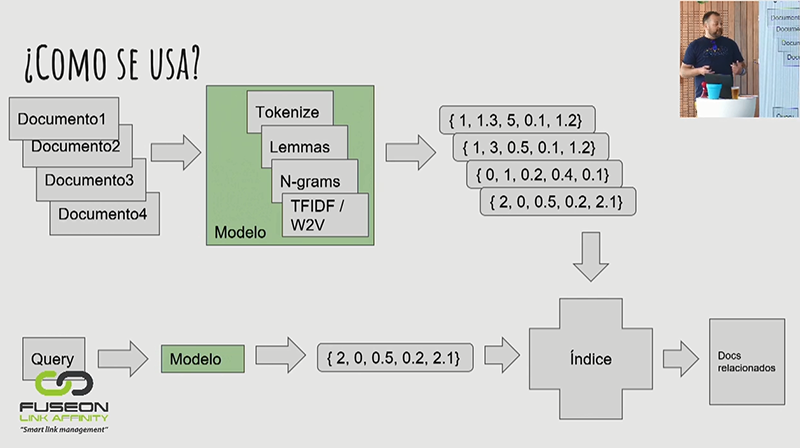

Para dar respuesta a estas cuestiones, Carlos explicó el modelo de espacio vectorial, el cual se puede aplicar a cualquier elemento: palabras, lemas, n-gramas, etc. También puso un ejemplo basado en frecuencia, teniendo en cuenta la frecuencia de cada palabra en el documento y la frecuencia de la palabra en todo el conjunto que estemos analizando. Continuó presentando el algoritmo Word2vec, el cual usa redes neuronales para aprender el contexto de cada palabra.

El siguiente punto de la presentación fue la explicación de cómo usar estos modelos para responder a una consulta. Aquí explicó que cada uno de los documentos se pasa por un modelo, o por varios de ellos, de los vistos anteriormente para obtener un conjunto de números, que sería su representación vectorial. Lo mismo se hace con la consulta. Así, la consulta se compara con el índice de documentos y se muestra una lista de documentos relacionados ordenados según la distancia a la consulta. Para obtener esta distancia, denominada similaridad semántica, se suele utilizar la función trigonométrica conocida como similaridad coseno entre vectores.

Carlos Pérez explicando cómo usar los modelos vectoriales para responder a una consulta

Carlos Pérez explicando cómo usar los modelos vectoriales para responder a una consulta

A continuación, usó este modelo con las 60 URL del sitio craneoprivilegiado.com que devuelve Google para la consulta link building. El modelo coloca en la posición 14 el documento que Google posiciona en primer lugar. La explicación que dio Carlos es porque es un documento muy extenso que trata muchos temas además del link building.

Para finalizar, trató los problemas de escalado que presenta el hacer este tipo de índices para cada consulta y cada URL. Así pues, la manera de construir un índice de este modo es clusterizando. Para ello mostró un par de ejemplos: el algoritmo K-means, que calcula la distancia entre la consulta y los documentos únicamente de su cluster, y el SPTAG, que es similar. Volvió a repetir los resultados de la web de craneoprivilegiado con SPTAG y obtuvo los mismos resultados que antes con el modelo de similaridad semántica.

Las respuestas están en las SERPS, con Gianluca Fiorelli

Gianluca Fiorelli, consultor SEO internacional, comenzó levantando la voz sobre una práctica que él cree cada vez más olvidada: observar las SERP y hacerlo de manera habitual, no únicamente después de una actualización de Google.

Siguió haciéndose eco de otro error que ve en el SEO y es el de pensar únicamente en los usuarios de nuestra página, cuando, según él, también debemos estar pensando en los usuarios de Google. Aquí hemos de tener en cuenta que Google no se fija únicamente en las palabras clave, sino que intenta satisfacer la intención de búsqueda que ha estimado para cada usuario.

Continuando con el tema de la intención de búsqueda, Gianluca hizo hincapié en 4 micromomentos:

- Momentos Quiero Saber. El usuario está buscando sobre ciertos temas y productos, pero no está necesariamente interesado en comprarlos. La intención de búsqueda es informacional y es la base sobre la que una página construye su autoridad y experiencia para Google.

- Momentos Quiero Ir. Cuando alguien está buscando un negocio local o pensando en comprar en una tienda cercana. Aquí la intención de navegación puede ser tanto offline como online, aunque la mayoría de las veces tiene un componente mixto.

- Momentos Quiero Hacer. Aquí se busca ayuda o instrucciones para realizar una tarea o probar algo nuevo. La intención de búsqueda es de nuevo informacional y también sirve para la construcción de autoridad y experiencia.

- Momentos Quiero Comprar. El cliente está listo para comprar, pero puede necesitar ayuda para decidir el qué o cómo realizar la compra. En estos casos en los resultados de búsqueda predominan los anuncios.

Los 4 tipos de micromomentos explicados por Gianluca

Los 4 tipos de micromomentos explicados por Gianluca

Prosiguió analizando una SERP con los resultados de búsqueda del nombre de una ciudad en el buscador italiano de Google. La SERP sacaba, además de los resultados orgánicos, el Knowledge Panel, elementos de Google Travel Guide y entidades relacionadas (otras ciudades y el país de todas ellas). Además, encontramos información adicional en las búsquedas relacionadas que Google nos ofrece al final de la página de resultados. También indicó que, con la misma búsqueda, si vamos a la pestaña de Images, encontramos entidades relacionadas en las etiquetas.

Respecto a ideas con las palabras clave, Google Suggest puede dar otras ideas, aunque no suelen ir mucho más allá de lo visto con las búsquedas relacionadas y las etiquetas de las imágenes. El bloque de “Otras preguntas de los usuarios” del buscador también es una fuente importante de búsquedas relacionadas y, por supuesto, herramientas SEO como MOZ, SEMrush, STAT Search Analytics y Ahrefs.

Volviendo al tema de mirar las SERP, aclaró que también debemos observar las otras páginas que se están posicionando, al menos para nuestras palabras clave más importantes. Para finalizar, explicó que ciertos resultados que pueden parecen de información porque combinan anuncios con resultados informacionales en las SERP, deben ser tratados como una forma mixta de página transaccional e informativa, para cubrir ambas necesidades y aumentar así el rendimiento para dichas consultas.

Why your campaigns fail, Laura Crimmons

Laura Crimmons, de Silverthorn Agency, comenzó su charla indicando que ella había trabajado en relaciones públicas hasta que hace 8 años pasó a una agencia SEO. Comentó que esa parte de relaciones públicas le había ayudado en asuntos de link building. Luego entró en materia y comenzó a desgranar cuáles son los motivos que pueden llevar a que una campaña fracase.

No conocer a tu audiencia, aquí habló de 2 audiencias diferentes. Por un lado, el cliente final y por otro lado una audiencia intermedia que serían los medios de comunicación y los influencers. Como ejemplo de todo ello puso un gráfico en el que la campaña ideal sería una en la que coinciden los intereses de nuestra audiencia, con los temas de los que están escribiendo los periodistas y lo que es relevante para nuestro negocio.

Sobre los periodistas, explicó que más del 41 % valoran si la historia que le proponen tiene potencial para compartirse en redes sociales antes de decidirse a escribirla. Además, el 68 % de los periodistas hacen un seguimiento de las veces que se comparten sus historias en las redes sociales.

Laura recordó la importancia de las imágenes, insistiendo en que siempre nos aseguremos de tener unas imágenes de alta calidad para acompañar una campaña. También ofreció datos sobre el porcentaje de contenido de vídeo que acompaña los artículos: 96 % Daily Mail, 95 % BBC News y 41 % The Guardian. Visto lo anterior, una campaña es más idónea si también tiene contenido de vídeo.

Las emociones son lo que lleva a la gente a compartir un contenido. Debemos conocer qué emociones despierta el contenido que desarrollamos.

Todo lo anterior, por sí mismo, no justifica el que nos pongan un enlace. Así pues, deberemos crear algo con lo que el periodista no pueda contar la historia sin enlazarlo.

Laura Crimmons durante su presentación

Laura Crimmons durante su presentación

Además, debemos explicar cuál es el valor que ofrece el enlace. Y también, elegir bien el momento. Sobre esto puso como ejemplo el de un contenido sobre Michael Jackson que saliera al mismo tiempo que se estrena el documental en el que se le acusa de pedófilo.

Resumiendo, los motivos por los que una campaña falla son:

- No conoces a tu audiencia.

- No entiendes que el tamaño importa (breve para un tuit, pero extenso para un artículo).

- No tienes el pack completo (texto, imagen y vídeo).

- Caes en tus propios prejuicios.

- No te mereces un enlace.

- La elección del momento es mala.

- Tus datos no son sorprendentes.

- Caes en la última valla.

Doing better on Google Images & Video, por Gary Illyes

Tomó el relevo el cabeza de cartel del congreso. Gary Illyes, analista de tendencias de Google, que habló sobre: cómo funciona Google, qué es el SEO y cómo mejorar el uso de Google Images y Google Video.

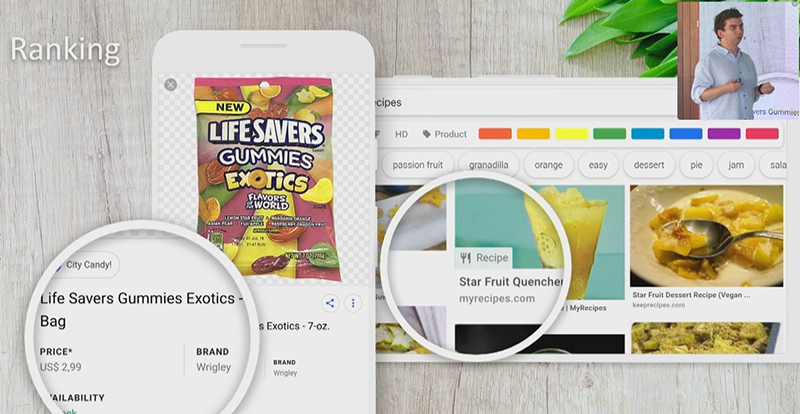

Comenzó mostrando una foto de su cocina y la búsqueda de “beautiful kitchens” en Google Images. Lo primero que remarcó fue que los títulos son muy importantes. En los resultados de imágenes también se muestran etiquetas, como por ejemplo Product, ya que vienen de una página con datos estructurados. Hay muchas oportunidades en las pestañas de imágenes y vídeos de Google que las páginas todavía no están utilizando y ese es uno de los principales motivos del porqué de la presentación de Gary.

Respecto a cómo funciona Google, Gary dio un repaso básico a los tres puntos que utiliza Google para crear sus resultados:

- Rastreo.

- Indexación.

- Clasificación.

Para contestar a qué es el SEO volvió a ofrecer tres puntos clave como respuesta:

- Asegurarnos de que los motores de búsqueda pueden acceder a las páginas y al contenido.

- Crear y optimizar el contenido de las páginas.

- Añadir y optimizar metadatos.

Gary Illyes impartiendo su ponencia

Gary Illyes impartiendo su ponencia

En la última parte, cómo mejorar en Google Images y Google Video, empezó diciendo que los archivos deben ser accesibles para el buscador, que no se encuentren en una carpeta que esté bloqueada por el archivo robots.txt, por ejemplo. También indicó que algunos CDN (content delivery network, red de distribución de contenido) dan problemas porque cambian las URL cada pocos minutos, lo que hace que las imágenes y los vídeos no se puedan indexar de forma correcta.

Los archivos sitemap son la principal fuente de descubrimiento de imágenes y vídeos para Google, por delante de los enlaces. También es importante que haya texto alrededor de la imagen para poder contextualizarla, así como tener relleno el atributo alt con un texto descriptivo y preciso. Igualmente, Gary volvió a nombrar la importancia de usar datos estructurados en las imágenes para destacar en los resultados de búsqueda de imágenes y en los vídeos para tener mayores posibilidades de ser indexados. El título y la descripción de la página también deben ser relevantes, de hecho, el ponente confirmó que Google reescribe los títulos y las descripciones si no los encuentra suficientemente relevantes.

Links that increases rankings, con Lisa Myers

Lisa Myers, CEO de Verve Search, comenzó su presentación presentado el caso de “Nominet” un cliente que estaba en el puesto 52 para la búsqueda “domain names” y que con 22 enlaces llegó hasta el número 2 en un par de meses. A continuación, indicó que, para el Reino Unido (el mercado donde hicieron el posicionamiento para Nominet), 73 páginas web tienen el 50 % del tráfico de Internet, dijo que en España el número era de 87.

Continuó diciendo que, pese a todos los cambios hechos por Google en su algoritmo, los clientes siguen pidiendo un número de links al mes. Sin embargo, ellos no valoran todos los links de la misma manera, así que desarrollaron una herramienta, Link Score, para puntuar cada enlace. Dicha herramienta evalúa docenas de métricas, entre ellas: idioma, relevancia, categoría del contenido, localización del enlace, penalizaciones, etc. La puntuación de cada enlace va de 0 a 500. Como ejemplo, la portada de la BBC tiene una puntación de 494.

Una vez explicado Link Score, volvió al ejemplo de Nominet, indicando que los 22 enlaces que habían conseguido tenían un Link Score de 3.000 e incluían sitios como la Universidad de Aberdeen, The Telegraph, Glamour, Yahoo! y Marie Claire.

Ejemplo de enlaces conseguidos para una campaña por Lisa Myers

Ejemplo de enlaces conseguidos para una campaña por Lisa Myers

Lisa explicó que para conseguir un enlace en estos sitios tienes que merecer más que un simple enlace. Además, los periodistas tienen que escribir mucho contenido al día, así que están deseosos de recibir buenos contenidos, que tengan potencial para ser compartidos y que conecten con su audiencia.

Durante la presentación, se vieron 2 ejemplos más de campañas, una para Lenstore, un vendedor de lentillas, y otra para Babylon, una aplicación de salud. Con Lenstore recibieron 159 enlaces, con más de 10.000 puntos de Link Score y 1.7 millones de visitas. Con Babylon fueron 158 enlaces, más de 7.000 puntos de Link Score y fue compartida 74.000 veces.

Para finalizar, habló de varias herramientas:

- Gorkana, para buscar contactos en los medios.

- BuzzStream, para buscar influencers y gestionar los contactos.

- Hunter.io para buscar direcciones de email.

Por último, mostró un ejemplo de cómo escribir emails de contacto para los medios. En el ejemplo, se ofrecía un contenido específico para la zona del periodista, se utilizaba una lista numerada, que es un formato muy visual y fácil de entender y también se acompañaba de una imagen. Por supuesto, se incluían 2 enlaces y se pedía por favor en uno de ellos que se mencionara el proyecto mediante ese enlace.